Multi-Cloud: Strategische Notwendigkeit statt technischer Option

Wie Unternehmen Resilienz und Digitale Souveränität vereinen

Die Cloud-Ausfälle vom Oktober 2025 haben es schonungslos offengelegt: Wer sein Business auf einen einzigen Hyperscaler setzt, spielt russisches Roulette mit der eigenen Wettbewerbsfähigkeit. Multi-Cloud ist längst keine technische Spielerei mehr, sondern eine Versicherungspolice für digitale Souveränität und Business Continuity in einer zunehmend fragilen Cloud-Welt.

„Wenn die Cloud hustet, kriegt das Internet Fieber.“

Mit diesem Satz übertitelte kürzlich der Techblogger und Digitalexperte Sascha Pallenberg einen Beitrag auf seinem Blog über die jüngsten Cloud-Outages. Cloud-Computing ist heute so selbstverständlich wie Strom oder Wasser. Und genau wie bei Strom oder Wasser merken wir erst, was fehlt, wenn plötzlich nichts mehr funktioniert. Die Abhängigkeit von einzelnen Hyperscalern schafft systemische Risiken, die vielen Entscheidern erst bei einem Ausfall bewusst werden. Doch dann ist es meist zu spät.

Im Oktober 2025 lieferten AWS und Microsoft Azure ein eindrucksvolles Live-Experiment, wie schnell digitale Geschäftsmodelle kollabieren können. Am 20. Oktober fiel AWS‘ kritische Region US-EAST-1 für über 15 Stunden aus: ein DNS-Auflösungsfehler hatte über 113 Services lahmgelegt, darunter Lambda, DynamoDB und CloudFormation. Nur Tage zuvor war Azure Front Door ausgefallen und hatte 30% der Kapazität in Europa, dem Nahen Osten und Afrika blockiert. Microsoft 365, Xbox Live, Azure SQL – alles weg.

Was diese Vorfälle so brutal deutlich machen: Selbst Tech-Giganten sind nicht unfehlbar. Eine Fehlkonfiguration, ein DNS-Fehler, ein Kubernetes-Pod-Crash – und globale Lieferketten stehen still, Millionen Nutzer sind betroffen. Die Zahlen von Cherry Servers sprechen eine klare Sprache: AWS-Störungen dauern durchschnittlich 1,5 Stunden, Google Cloud-Ausfälle 5,8 Stunden, und Azure-Disruptions im Durchschnitt 14,6 Stunden. Im Extremfall dauerte eine Azure-Störung in China North 3 sogar 50 Stunden. Mehr als zwei Tage.

Die These: Multi-Cloud ist keine Spielwiese für Technik-Enthusiasten mehr. Sie wird zunehmend ine betriebswirtschaftliche Notwendigkeit, wie eine Versicherungspolice für Business Continuity und digitale Souveränität.

Strategische Treiber: Warum Unternehmen diversifizieren müssen

Resilienz & Business Continuity

Der Single Point of Failure ist der Albtraum jedes und jeder CIO. Wenn ein Provider ausfällt, muss der Betrieb weiterlaufen, nicht erst nach Stunden, sondern idealerweise nahtlos. Doch es geht hier nicht nur um einfache Datensicherung, sondern um etwas Fundamentaleres: Operational Resilience. Die Fähigkeit, Workloads bei Bedarf zu verschieben und Services ohne Unterbrechung aufrechtzuerhalten.

Die Oktober-2025-Ausfälle haben ein gemeinsames Muster offengelegt: Kleine interne Änderungen – ein DNS-Metadata-Update hier, eine Routing-Policy-Regel dort – propagieren unkontrolliert durch mehrere Systemschichten und führen zu kaskadenartigen Ausfällen. Die Komplexität moderner Cloud-Infrastrukturen birgt inhärente Schwachstellen, die sich nicht einfach wegpatchen lassen.

Digitale Souveränität & Compliance

Wer die rechtliche Dimension von Cloud-Computing unterschätzt, bekommt früher oder später ein böses Erwachen. Der US CLOUD Act von 2018 erlaubt US-Behörden den Zugriff auf Daten amerikanischer Cloud-Provider – unabhängig vom physischen Speicherort. Selbst wenn Ihre Daten ausschließlich in EU-Rechenzentren liegen, unterliegen sie potenziell US-Jurisdiktion, sofern der Provider amerikanisch ist.

Die Schrems-II-Entscheidung des Europäischen Gerichtshofs von 2020 hat diese Problematik verschärft. Das Urteil invalidierte das Privacy Shield Agreement zwischen EU und USA, weil US-Überwachungsgesetze keinen angemessenen Schutz für EU-Daten bieten. Die Konsequenz für Unternehmen: Der Einsatz von US-Cloud-Providern für personenbezogene Daten ist rechtlich heikel und erfordert zusätzliche Schutzmaßnahmen wie Ende-zu-Ende-Verschlüsselung mit EU-basiertem Key-Management.

Hier kommt Gaia–X ins Spiel, Europas Initiative für eine sichere, föderierte Dateninfrastruktur. Die 2019 als deutsch-französische Initiative gestartete Plattform zielt darauf ab, ein Ökosystem zu schaffen, das digitale Souveränität der Dateninhaber, Interoperabilität und Open-Source-Prinzipien vereint. Das Bundesministerium für Wirtschaft bezeichnet das Vorantreiben von Gaia-X als eine der wichtigsten Maßnahmen der deutschen Datenstrategie. Nicht ohne Grund.

Die pragmatische Lösung liegt in der Trennung von Daten und Infrastruktur: Hochsensible Daten verbleiben unter lokaler Kontrolle oder bei europäischen Anbietern, während skalierbare Workloads ohne kritische Daten in die Public Cloud wandern können. Best of both worlds.

Vermeidung von Vendor Lock-in

Vendor Lock-in ist mehr als nur ein technisches Problem – es ist eine strategische Falle. Wer sich zu stark an einen Provider bindet, verliert nicht nur Verhandlungsmacht, sondern auch Flexibilität in der Produktauswahl und bei Innovationen. Und man wird zur Geisel seiner eigenen Architekturentscheidungen.

Eine durchdachte Multi-Cloud-Strategie hingegen ermöglicht es, die Stärken verschiedener Provider zu nutzen: Google für AI und Data Analytics, Azure für nahtlose Office-365-Integration, AWS für umfassende Compute-Ressourcen. Dieser Best-of-Breed-Ansatz maximiert den Geschäftswert und stärkt die Verhandlungsposition erheblich. Plötzlich ist man nicht mehr Bittsteller, sondern Kunde auf Augenhöhe.

Architektonische Umsetzung: Wie sieht eine resiliente Multi-Cloud aus?

Grundkonzepte: Hybrid Cloud vs. Multi-Cloud

Hybrid Cloud kombiniert On-Premises-Infrastruktur mit Public Cloud, während Multi-Cloud mehrere Public Cloud Provider nutzt. In der Praxis werden beide Ansätze häufig kombiniert – kritische Workloads bleiben On-Prem oder in privaten Clouds, während elastische Workloads auf mehrere Public Clouds verteilt werden. Die Kunst liegt darin, die richtige Balance zu finden.

Architektur-Modelle für Hochverfügbarkeit

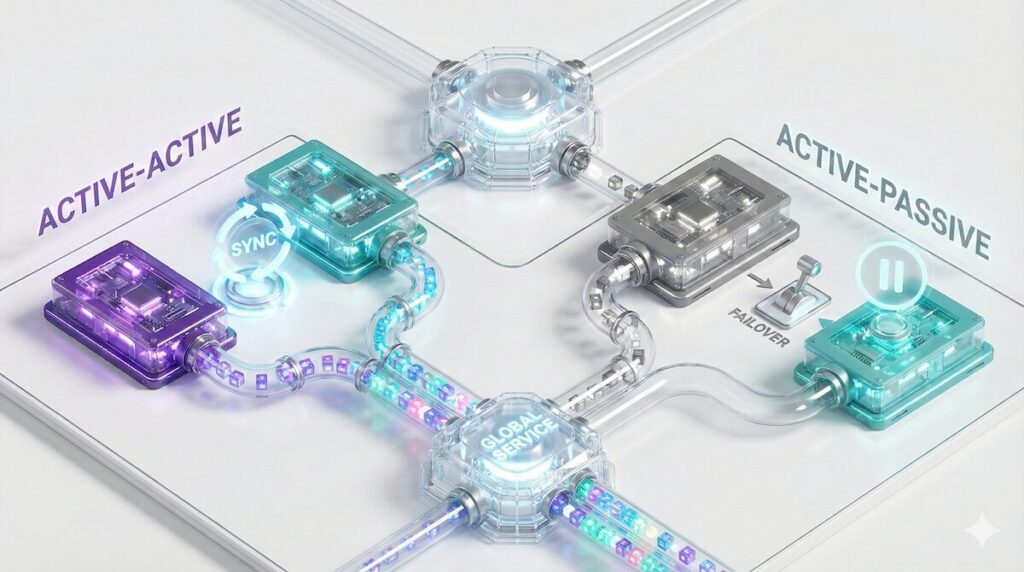

Active-Active (Hot Standby): Workloads laufen parallel auf mehreren Clouds. Fällt eine aus, übernehmen die anderen sofort – Zero Downtime. Dieses Modell ist teuer und komplex, da es Datenkonsistenz über mehrere Clouds hinweg sicherstellen muss. Für geschäftskritische Anwendungen wie Payment-Systeme oder globale E-Commerce-Plattformen ist es jedoch unverzichtbar.

Active-Passive (Warm/Cold Standby): Ein primärer Provider läuft im Normalbetrieb, ein sekundärer steht für den Notfall bereit. Kosteneffizienter, aber mit Umschaltzeiten verbunden. Bei Warm Standby sind Ressourcen bereits provisioniert und müssen nur aktiviert werden – Recovery Time Objective von Minuten bis Stunden. Bei Cold Standby müssen Ressourcen erst hochgefahren werden: RTO von Stunden bis Tagen. Die Wahl hängt davon ab, wie viel Downtime man sich leisten kann. Oder will.

Technische Enabler

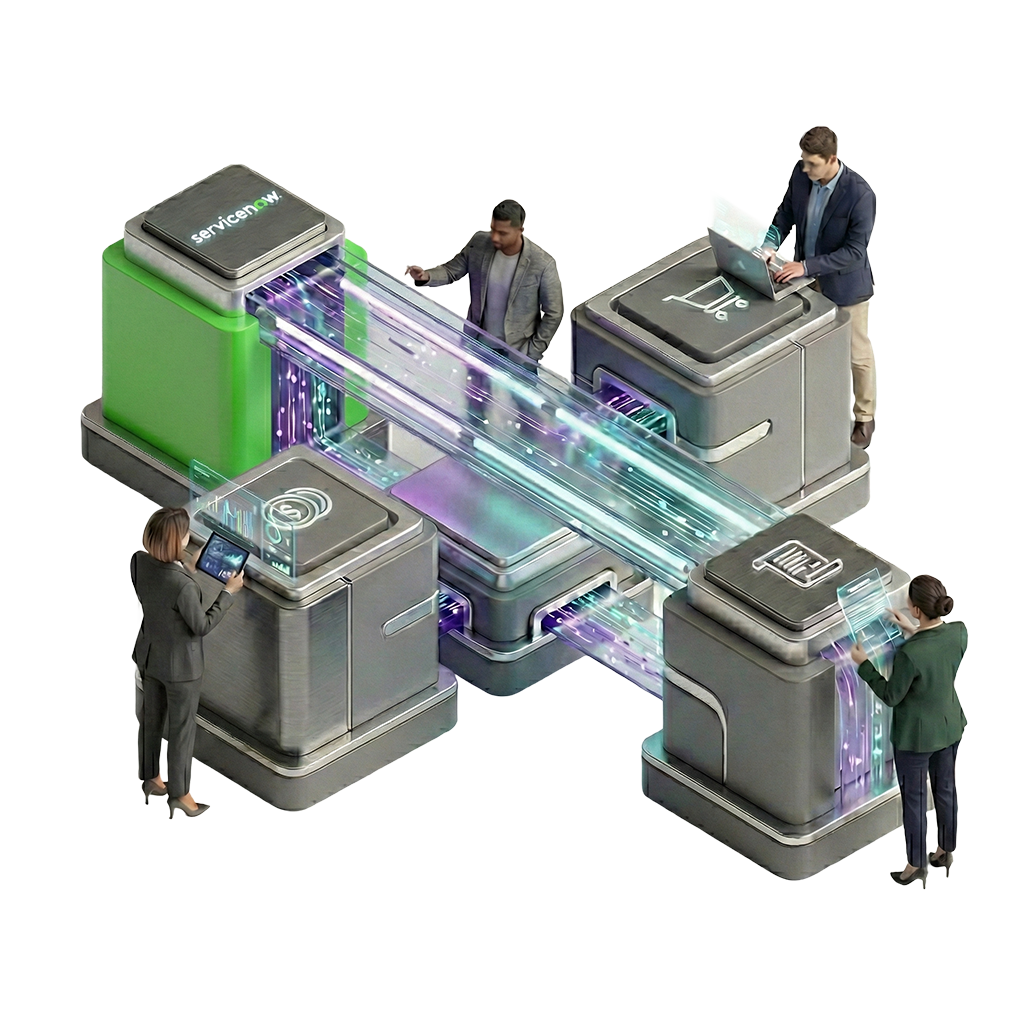

Container & Kubernetes: Die Containerisierung ist der Schlüssel zur Cloud-Portabilität. Kubernetes entkoppelt Anwendungen von der darunterliegenden Infrastruktur und ermöglicht nahtlose Migration zwischen Clouds. Cloud-native Anwendungen in Containern können mit minimalen Anpassungen zwischen AWS sEKS, Azure AKS und Google GKE verschoben werden. Was früher Wochen dauerte, ist heute eine Frage von Stunden.

Cross-Cloud Konnektivität: Für echte Multi-Cloud-Architekturen ist performante Konnektivität essentiell. Google Cloud’s Cross-Cloud Interconnect ermöglicht direkte Layer-2/3-Verbindungen zwischen verschiedenen Cloud-Providern ohne Umweg über das öffentliche Internet. SD-WAN-Lösungen bieten zusätzlich intelligentes Routing und Failover-Mechanismen über mehrere Clouds hinweg. Das Ergebnis: niedrige Latenz und hohe Zuverlässigkeit.

Governance & Sicherheit: Die Komplexität beherrschen

Die Herausforderung: Dashboard Fatigue

Jeder Cloud-Provider hat eigene APIs, Sicherheitsmodelle und Dashboards. Das Resultat: Dashboard Fatigue und ein erhöhtes Risiko für Fehlkonfigurationen. Die sind laut aktuellen Studien für über 80% der Cloud-Sicherheitsvorfälle verantwortlich: ein offener S3-Bucket hier, eine zu weit gefasste IAM-Policy dort. Kleine Fehler mit großer Wirkung.

Lösung 1: Cloud Center of Excellence (CCoE)

Ein Cloud Center of Excellence ist kein Kontrollgremium, sondern ein Enabler. Ein zentrales Team definiert Standards, Best Practices und Governance-Richtlinien, unterstützt aber gleichzeitig die dezentralen Teams bei der Umsetzung. Das CCoE fungiert als Bindeglied zwischen Sicherheit, Compliance und Innovation. Ein Balanceakt, der sich auszahlt.

Lösung 2: Policy as Code (PaC)

Policy as Code automatisiert die Durchsetzung von Sicherheitsregeln über alle Clouds hinweg. Tools wie Open Policy Agent oder HashiCorp Sentinel ermöglichen es, Policies in Code zu definieren und automatisiert durchzusetzen. Ein Beispiel: Eine Policy verhindert, dass S3-Buckets oder Azure Storage Accounts öffentlich zugänglich sind – egal in welcher Cloud. Der AWS Security Blog beschreibt PaC treffend als „governance at scale“, die Fähigkeit, Compliance-Anforderungen in Hunderten oder Tausenden von Accounts konsistent durchzusetzen, ohne manuelle Reviews.

Lösung 3: Shared Responsibility Model verstehen

Das Shared Responsibility Model ist fundamental, wird aber oft missverstanden: Der Cloud-Provider ist verantwortlich für die Sicherheit der Cloud – Infrastruktur, physische Sicherheit, Netzwerk. Der Kunde ist verantwortlich für die Sicherheit in der Cloud – Daten, Endpunkte, Identity & Access Management. Diese Verantwortung bleibt bestehen, egal bei welchem Provider. Klingt simpel, wird aber häufig vergessen. Mit fatalen Folgen.

FinOps: Kostenkontrolle in verteilten Umgebungen

Das Kosten-Risiko

Multi-Cloud bedeutet auch Multi-Complexity bei den Kosten. Ohne rigorose Kontrolle drohen versteckte Kosten, die den ROI zunichte machen. Egress-Gebühren sind dabei nur die Spitze des Eisbergs: 1 TB Datentransfer von AWS zu Azure kann schnell 90 USD kosten. Dazu kommen „Zombie-Ressourcen“: vergessene VMs, ungenutzte Volumes oder verwaiste Load Balancer, die Monat für Monat Kosten verursachen. Und dann ist da noch das Overprovisioning: vorsichtshalber zu groß dimensionierte Instanzen, die nur zu 20% ausgelastet sind. Die Summe dieser stillen Kostentreiber ist oft beeindruckend. Im negativen Sinne.

FinOps-Strategien

Shared Language etablieren: FinOps schafft eine gemeinsame Sprache zwischen Finanz- und IT-Teams. Technische Metriken werden in finanzielle KPIs übersetzt, sodass beide Seiten die Cloud-Ausgaben verstehen und optimieren können. Plötzlich sprechen Controller und DevOps-Engineers dieselbe Sprache.

Multi-Cloud Cost Management Tools: Tools wie Flexera, CloudZero oder nOps normalisieren Abrechnungsdaten über mehrere Clouds hinweg und machen Kosten vergleichbar. Sie identifizieren Anomalien, prognostizieren Ausgaben und empfehlen Optimierungen. Transparenz ist der erste Schritt zur Kostenkontrolle.

Automatisierung: Automatisches Abschalten von Dev/Test-Umgebungen außerhalb der Geschäftszeiten. Automatisches Rightsizing von Instanzen basierend auf tatsächlicher Nutzung. Automatische Identifikation und Löschung von Zombie-Ressourcen. Was automatisiert werden kann, sollte automatisiert werden, denn die Einsparpotenziale sind erheblich.

Ausblick: Der Weg zur souveränen IT

Multi-Cloud ist ein Schlüssel zu Resilienz und digitaler Souveränität – aber kein Selbstläufer. Eine erfolgreiche Implementierung erfordert einen hohen Reifegrad in Automatisierung, Governance und organisatorischer Transformation.

Die Oktober-2025-Ausfälle bei AWS und Azure haben eindrucksvoll gezeigt: Resilienz ist nicht automatisch gegeben, sie ist das Resultat bewusster architektonischer Entscheidungen, disziplinierter Prozesse und kontinuierlicher Investitionen in Testing und Recovery-Planung. Wie ein Experte treffend formulierte: Die Frage ist nicht, wie man Ausfälle vermeidet, sondern wie man sie mit minimalem Impact auf Betrieb und Kunden überlebt.

Die Zukunft liegt in föderierten Datenökosystemen: Initiativen wie Gaia-X zeigen den Weg zu einer souveränen, interoperablen Dateninfrastruktur. Die intelligente Verteilung von Workloads nach Risikoklasse wird zum Standard: hochsensible Daten und geschäftskritische Prozesse in souveränen Umgebungen, elastische Workloads in der Multi-Cloud.

Call to Action: Drei konkrete Schritte

1. Assessment durchführen: Klassifizieren Sie Ihre Workloads nach Kritikalität, Compliance-Anforderungen und Cloud-Eignung. Identifizieren Sie Single Points of Failure in Ihrer aktuellen Architektur.

2. Cloud Center of Excellence aufbauen: Etablieren Sie ein zentrales Team, das Standards definiert, Governance sicherstellt und als Enabler für dezentrale Teams fungiert. Implementieren Sie Policy as Code für konsistente Sicherheit über alle Clouds.

3. Exit-Strategie entwickeln: Containerisieren Sie kritische Anwendungen, vermeiden Sie proprietäre Cloud-Services wo möglich, und etablieren Sie regelmäßige Disaster-Recovery-Tests über Cloud-Grenzen hinweg.

Multi-Cloud-Strategien sind heute unerlässlich für Unternehmen, die auf digitale Resilienz und Souveränität setzen. Die jüngsten Ausfälle bei AWS und Azure haben gezeigt: Ein Single Point of Failure kann globale Geschäftsprozesse zum Erliegen bringen. Eine durchdachte Multi-Cloud-Architektur kombiniert Active-Active- oder Active-Passive-Modelle mit Container-Technologien und Cross-Cloud-Konnektivität. Dabei sind drei Säulen entscheidend: Ein Cloud Center of Excellence für Governance, Policy as Code für automatisierte Sicherheit und FinOps-Praktiken für Kostentransparenz. Wer jetzt mit einem klaren Assessment, dem Aufbau eines CCoE und einer soliden Exit-Strategie handelt, sichert sich nicht nur gegen Ausfälle ab, sondern gewinnt strategische Flexibilität und digitale Souveränität zurück. Multi-Cloud ist dann keine bloße Option mehr, sondern die Grundlage zukunftssicherer IT.

Abschließend noch ein Veranstaltungshinweis

Multi-Cloud löst technische Resilienz-Probleme, doch die wirklich schwierigen Fragen gehen darüber hinaus. Denn während wir über Verfügbarkeit und Vendor Lock-in diskutieren, wächst im Hintergrund ein anderes Problem: der ökologische Fußabdruck unserer digitalen Infrastrukturen. Rechenzentren verbrauchen heute etwa 1-2% der weltweiten Elektrizität, Tendenz steigend. Multi-Cloud kann diesen Verbrauch noch erhöhen, wenn Datenreplikation und Cross-Cloud-Traffic nicht effizient gemanagt werden.

Das Paradoxe daran: Während europäische Hyperscaler zunehmend zu Transparenz über ihre CO2-Emissionen verpflichtet werden und viele auf erneuerbare Energien setzen, fehlt es bei vielen globalen Anbietern noch an vergleichbaren Standards. Wir wissen oft mehr über die Verfügbarkeit unserer Cloud-Services als über deren Umweltkosten – ein blinder Fleck, den sich Unternehmen mit ESG-Ambitionen nicht mehr leisten können.

Und dann ist da noch die Frage der Werte. Digital Sovereignty bedeutet nicht nur technische Kontrolle über Daten, sondern auch die Frage: In welchem Rechts- und Werteraum bewegen wir uns? Die unterschiedlichen Auffassungen von Datenschutz, Überwachung und digitalen Grundrechten zwischen den USA und Europa sind nicht nur juristische Spitzfindigkeiten. Sie spiegeln fundamentale gesellschaftliche Entscheidungen wider. In einer Zeit, in der KI-Systeme zunehmend Entscheidungen treffen, die Menschen betreffen, wird diese Frage noch dringlicher: Nach wessen Regeln und Werten soll die KI handeln?

Wenn Sie mit uns und weiteren Experten zu den Themen Digitale Souveränität, nachhaltige IT und verantwortungsvoll eingesetzte KI diskutieren möchten, dann gibt es dazu am 15. Januar 2026 Gelegenheit. Gemeinsam mit SustainableIT.org und resilio laden wir Sie gerne zu unserer Veranstaltung „Europa at a Crossroads: Responsible AI, Sustainability & Digital Sovereignty“ in den Impact Hub Zürich ein. Kostenlose Anmeldung unter: https://luma.com/k0jeiyy3